ChatGPT: Révolution ou menace ?

ChatGPT : entre révolution technologique et dilemme de confidentialité. Découvrez le potentiel et les pièges.

ChatGPT : entre révolution technologique et dilemme de confidentialité. Découvrez le potentiel et les pièges.

Depuis le déploiement mondial de ChatGPT par OpenAI, les opinions divergent. Certains estiment qu'il va révolutionner notre mode de vie et de travail, tandis que d'autres expriment leur inquiétude quant à son potentiel de bouleversement, notamment en ce qui concerne la confidentialité des individus et des organisations.

Des incidents ont déjà eu lieu comme des informations sensibles qui ont été exposées, et des employés qui ont dû faire face à des conséquences suite à la saisie de données confidentielles de l'entreprise dans le chatbot. Un exemple:

Samsung a pris des mesures suite aux révélations selon lesquelles trois de ses employés ont divulgué des données sensibles en utilisant ChatGPT. Les travailleurs étaient autorisés à utiliser le chatbot pour expérimenter la résolution des problèmes dans le code source de l'entreprise. SOURCE: TECHMONITOR.AI

Certains pays ont même imposé une interdiction temporaire de son utilisation dans le but de protéger les données.

Posons-nous donc les questions suivantes:

Que fait exactement ChatGPT avec nos informations et comment pouvons-nous l'utiliser de manière sécurisée ?

Quels sont les bénéfices en terme de cybersécurité?

Quels sont les risques?

L'article suivant essayera de répondre au maximum aux questions importantes autour de ChatGPT.

Avant de se lancer dans les risques, les questions-réponses, les bénéfices et tout le reste, savez-vous ce qu'est CHATGPT?

Si oui, lisez quand même la suite.

Si non, lisez surtout bien la suite.

Et quoi de mieux pour définir ChatGPT que ChatGPT lui même !

ChatGPT:

ChatGPT est un modèle de langage artificiel développé par OpenAI. Basé sur l'architecture GPT (Generative Pretrained Transformer), il est capable de générer du texte de manière autonome, de répondre aux questions, de rédiger des essais, de créer et de déboguer du code, de résoudre des équations mathématiques complexes et même de traduire entre différentes langues.

Il a été "entraîné" sur une grande quantité de données provenant d'Internet, y compris des livres, Wikipedia, des articles et d'autres contenus en ligne. Cela lui donne la capacité de comprendre et de générer du texte de manière conversationnelle, bien qu'il ne comprenne pas le sens du texte de la même manière que le ferait un humain.

Il est important de noter, bien que ChatGPT soit capable de produire des réponses impressionnantes, que ses réponses sont basées sur des motifs dans les données sur lesquelles il a été formé, et non sur une compréhension réelle du monde.

SOURCE: CHATGPT

Cependant, en tant qu'outil de traitement du langage naturel, son fonctionnement est basé sur la probabilité. Il génère des réponses en prédisant le mot suivant dans une phrase, en s'appuyant sur les millions d'exemples sur lesquels il a été formés.

ChatGPT conserve les demandes/prompts des utilisateurs ainsi que ses réponses pour continuellement affiner ses algorithmes.

Même après la suppression de vos interactions, le bot conserve la capacité d'utiliser ces données pour améliorer ses capacités d'IA. Cette situation pourrait potentiellement être risquée si les utilisateurs saisissent des données personnelles ou organisationnelles sensibles qui pourraient être attrayantes pour des entités malveillantes en cas de violation de données.

De plus, il archive également d'autres détails personnels lorsqu'il est en fonctionnement, tels que la localisation géographique approximative de l'utilisateur, l'adresse IP, les informations de paiement et les spécifications de l'appareil (bien que ce type de collecte de données soit courant pour la plupart des sites Web à des fins analytiques, et donc, pas exclusif à ChatGPT).

Les techniques de collecte de données déployées par OpenAI ont suscité l'inquiétude chez certains chercheurs, étant donné que les données extraites pourraient englober du matériel protégé par des droits d'auteur.

Il semble que ChatGPT soit de plus en plus exploité à des fins malveillantes. Ses compétences en matière d'écriture de code peuvent être utilisées pour créer des logiciels malveillants, développer des sites web obscurs et exécuter des cyber-attaques.

Plusieurs cas d'écriture de codes malveillants, de mails de phishings et autres techniques de cyberattaques ont été rapporté par des utilisateurs. Comme par exemple l'orchestration d'attaques d'hameçonnage très raffinées. En améliorant le langage utilisé, ChatGPT supprime les signes révélateurs d'une orthographe et d'une grammaire médiocres souvent associés aux tentatives d'hameçonnage. En outre, il a été utilisé pour mieux comprendre la psychologie des destinataires ciblés, dans le but d'induire un stress et d'accroître ainsi l'efficacité des attaques de phishing.

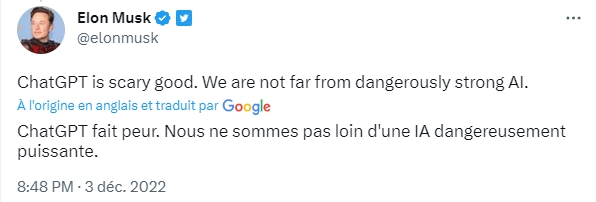

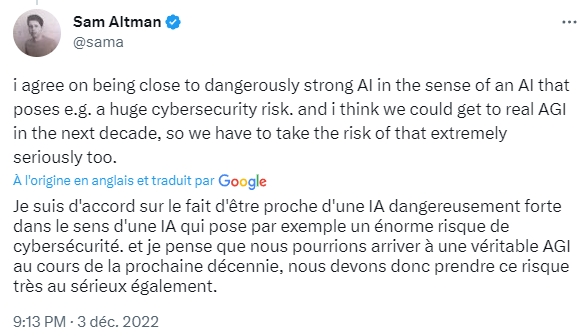

En mars 2023, plus d'un millier d'experts en IA, dont les cofondateurs de l'OpenAI Elon Musk et Sam Altman, ont plaidé en faveur d'un arrêt immédiat de la production des principaux outils d'IA générative pendant au moins six mois. Cette pause doit permettre aux chercheurs de comprendre les risques associés à ces outils et d'élaborer des stratégies d'atténuation.

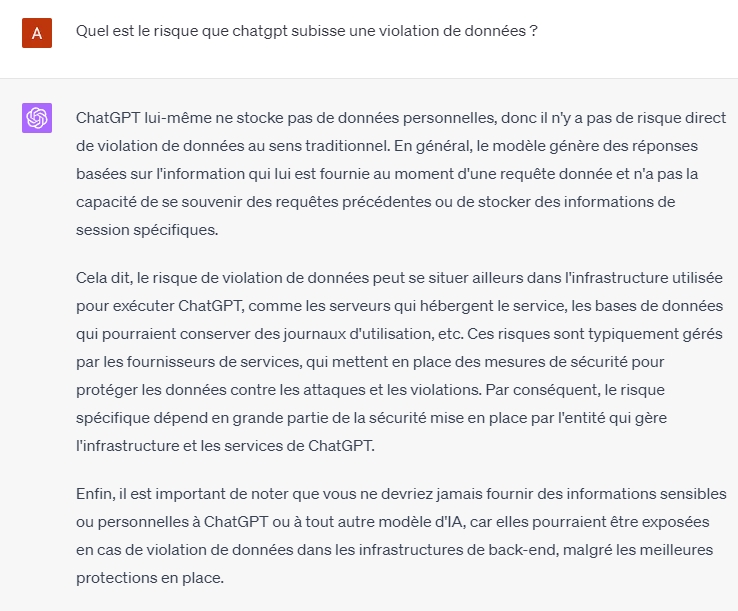

Quelles violations de données ont eu lieu jusqu'à présent ? OpenAI a confirmé qu'un bogue dans le code source du chatbot a pu provoquer une fuite de données en mars 2023, permettant à certains utilisateurs de voir des parties de l'historique de chat d'un autre utilisateur actif. Il est également possible que des informations relatives au paiement de 1,2 % des abonnés de ChatGPT Plus qui étaient actifs pendant une période donnée aient été mises à disposition.

OpenAI a publié une déclaration dans laquelle elle estime que le nombre d'utilisateurs dont les données ont été révélées est "extrêmement faible", car il aurait fallu qu'ils ouvrent un courriel d'abonnement ou qu'ils cliquent sur certaines fonctions dans une séquence spécifique au cours d'une période donnée pour être affectés. Néanmoins, ChatGPT a été mis hors ligne pendant plusieurs heures, le temps que le bug soit corrigé.

Avant cela, Samsung a connu trois incidents distincts au cours desquels des informations confidentielles de l'entreprise ont été introduites dans le chatbot (le code source de Samsung, la transcription d'une réunion de l'entreprise et une séquence de test pour identifier les puces défectueuses), ce qui a donné lieu à des enquêtes disciplinaires.

Les données n'ont pas été divulguées pour autant que nous le sachions, mais comme mentionné ci-dessus, tout ce qui est entré dans ChatGPT est stocké pour entraîner son algorithme, de sorte que les informations confidentielles entrées par les membres du personnel de Samsung sont, en théorie, maintenant disponibles pour toute personne utilisant la plateforme.

OpenAI déclare effectuer des tests annuels pour identifier les faiblesses de sécurité et empêcher qu'elles ne soient exploitées par des acteurs malveillants. Elle gère également un "programme de récompense des bugs", invitant les chercheurs et les pirates éthiques à tester la sécurité du système pour détecter les vulnérabilités en échange d'une récompense en espèces.

Comme pour toutes les applications numériques, ChatGPT déclare:

" Si vous avez des inquiétudes concernant la confidentialité ou la sécurité de vos interactions avec ChatGPT, il est conseillé d'éviter de partager toute information personnelle identifiable ou sensible. Bien que l'OpenAI vise à fournir un environnement sécurisé, il est essentiel de faire preuve de prudence lorsque l'on interagit avec des systèmes d'IA ou toute plateforme en ligne".

Un autre conseil général est de créer un mot de passe fort et unique et de fermer l'application après l'avoir utilisée, en particulier sur des appareils partagés. Il est également possible de refuser que ChatGPT stocke des données en remplissant un formulaire en ligne:

En avril 2023, OpenAI a introduit une nouvelle fonctionnalité permettant aux utilisateurs de désactiver l'historique des conversations. Les conversations entamées après avoir activé cette fonction ne sont pas stockées pour entraîner l'algorithme et n'apparaissent pas dans la barre latérale de l'historique, mais elles sont conservées pendant 30 jours avant d'être définitivement supprimées.

SOURCE: TECHTARGET

-> Les images ci-dessous sont générées par MidJourney:

Midjourney est un laboratoire de recherche indépendant qui produit un programme d'intelligence artificielle sous le même nom et qui permet de créer des images à partir de descriptions textuelles, suivant un fonctionnement similaire à celui de DALL-E d'OpenAI.

ChatGPT pourrait aider les analystes des centres d'opérations de sécurité (SOC) surchargés de travail en analysant automatiquement les incidents de cybersécurité et en faisant des recommandations stratégiques pour aider à informer les mesures de défense immédiates et à long terme.

Par exemple, plutôt que d'analyser le risque d'un script PowerShell donné à partir de zéro, un analyste SOC pourrait s'appuyer sur l'évaluation et les recommandations de ChatGPT. Les équipes SecOps peuvent également poser à OpenAI des questions plus générales, telles que la manière d'empêcher l'exécution de scripts PowerShell dangereux ou le chargement de fichiers à partir de sources non fiables, afin d'améliorer les mesures de sécurité globales de leur organisation.

Les paramètres de ChatGPT impliquent qu'il ne répondra pas aux demandes qu'il considère comme suspectes, mais les utilisateurs continuent de découvrir des failles. Par exemple, si l'on demande à ChatGPT d'écrire un code de ransomware, il refusera de le faire. Mais de nombreux chercheurs en cybersécurité ont indiqué qu'en décrivant des tactiques, des techniques et des procédures pertinentes - sans utiliser de mots d'alerte tels que malware ou ransomware - ils peuvent amener le chatbot à produire du code malveillant.

Les créateurs de ChatGPT tenteront probablement de combler ces lacunes au fur et à mesure qu'elles apparaîtront, mais il semble plausible que les attaquants continueront à trouver des solutions de contournement. La bonne nouvelle est que les testeurs de pénétration peuvent également utiliser ces failles pour simuler le comportement réaliste d'un adversaire à travers divers vecteurs d'attaque dans le but d'améliorer les contrôles défensifs.

Les rapports détaillés sur les incidents de cybersécurité jouent un rôle essentiel en aidant les principales parties prenantes - c'est-à-dire les équipes SecOps, les responsables de la sécurité, les dirigeants d'entreprise, les auditeurs, les membres du conseil d'administration et les secteurs d'activité - à comprendre et à améliorer la posture de sécurité d'une organisation.

Cependant, la production de rapports d'incidents est un travail long et fastidieux. Les praticiens de la cybersécurité pourraient utiliser ChatGPT pour rédiger des rapports en fournissant à l'application des détails tels que les suivants :

La cible de la compromission ou de l'attaque.

Les scripts ou shells utilisés par les attaquants.

Les données pertinentes de l'environnement informatique.

En déchargeant ChatGPT de certaines tâches d'établissement de rapports sur la cybersécurité, les intervenants en cas d'incident pourraient consacrer plus de temps à d'autres activités essentielles.

De cette manière, l'IA générative pourrait contribuer à atténuer les problèmes d'épuisement professionnel et de manque de personnel dans le domaine de la cybersécurité.

Les spécialistes de la recherche sur les menaces ont aujourd'hui accès à une quantité sans précédent de renseignements sur la cybersécurité provenant de sources telles que l'infrastructure de leur entreprise, les flux de renseignements sur les menaces externes, les rapports sur les violations de données accessibles au public, le dark web et les médias sociaux. Bien que la connaissance soit un pouvoir, les humains ne peuvent pas analyser et synthétiser de manière cohérente une telle quantité d'informations de manière significative.

L'IA générative, en revanche, pourrait bientôt faire ce qui suit presque instantanément :

Consommer de vastes volumes de données de renseignements sur les menaces provenant de diverses sources.

Identifier des schémas dans les données.

Créer une liste de nouvelles tactiques, techniques et procédures adverses.

Recommander des stratégies de cyberdéfense pertinentes.

Avec ChatGPT, les équipes de cybersécurité pourraient éventuellement être en mesure d'obtenir une compréhension complète, précise et actualisée du paysage des menaces en un instant, afin d'ajuster leurs contrôles de sécurité en conséquence.

Votre avis m'intéresse:

Que pensez-vous de CHATGPT ou tout autre IA?

Avez-vous des craintes ou au contraire êtes-vous très enthousiaste ?

Voyez-vous des limites, un potentiel ou juste une tendance?